Lấy ví dụ như cái mạng nhện trong nhà bạn ấy, nhà bạn nào sạch quá ko có mạng nhện thì qua nhà hàng xóm xin coi cái mạng nhện như nào. Những cái weight này giống như mấy đường nối của mạng nhện, còn mấy cái điểm giao của mạng nhện cũng như là neural. Ok chưa?. (thực ra chả liên quan gì đâu :/ ).

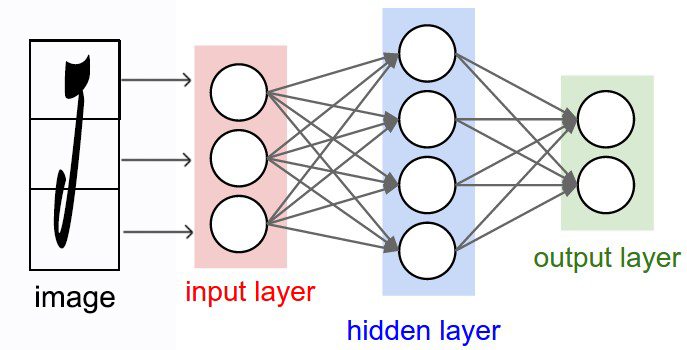

Nói vòng vo nãy h, vậy cuối cùng neural là gì, có nhiệm vụ làm gì? Các bạn cứ hiểu neural là cái phòng để tính toán xử lí các dữ liệu dựa vào input và weight. Ở đây, nó sẽ làm phép tính tổng của các tích WiXi (Trong đó Wi là weight, và Xi là input). Nghe quen không? Nó y chang như cái hàm linear classifier trong bài function score đấy.

[latex]F = Wx .[/latex]

Sau khi qua căn phòng tính toán. Giá trị sẽ được đi qua 1 hàm transfer function ( hay Activation function). Hàm này sẽ tiếp tục xử lý tùm lum tá lả để đưa ra 1 giá trị output. Vậy hàm activation function này là gì? Activation function:

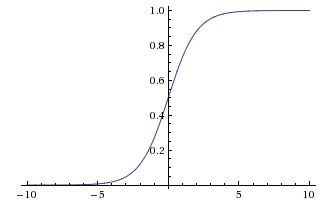

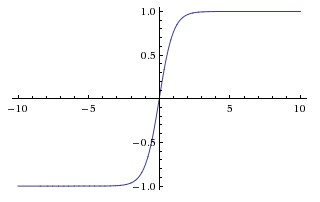

Thực ra activation function là một hàm toán học thôi, định nghĩa vậy là dễ hiểu nhất. Có rất nhiều loại Activation function nhé, sau đây mình sẽ giới thiệu qua một số hàm activation function chính, và mình cũng giới thiệu công thức thôi. Còn mấy vụ giải thích mặt toán học để xem xét nó xịn chỗ nào, nó cùi chỗ nào thì mình sẽ ko bàn tới nhé.Sigmoid:Hàm này có công thức:

[latex]\sigma (x)= \frac{1}{1+e^{-x}}[/latex]

Giá trị x sau khi đi vào hàm này sẽ cho kết quả là 1 giá trị trong khoảng 0 – 1.

[latex]tanh(x)=2\sigma (2x)-1[/latex]

[latex]f(x)=max(0,x)[/latex]

Hàm này lấy giá trị của x nếu x>0. Nếu x<0 0.="" alt="ReLU" class="aligncenter" gi="" h="" img="" m="" src="https://orig00.deviantart.net/134c/f/2018/290/4/b/relu_by_toiyeumayhoc-dcpnv5m.jpg" tr="" v="">Ngoài ra còn có rất nhiều hàm activation function khác mà mình sẽ không kể đến. Mỗi hàm sẽ có ưu nhược điểm riêng, tùy theo bài toán giải quyết mà người ta sẽ lựa chọn cho phù hợp.

0 Nhận xét